生成AI(ChatGPTやGeminiなど)を使っていると、驚くほど自然な文章で、全くのデタラメを回答されたことはありませんか?

「実在しない本の感想を教えてくれた」

「聞いたこともない歴史上の出来事を自信満々に語られた」……。

このように、AIがもっともらしい嘘をつく現象を「ハルシネーション(幻覚)」と呼びます。

なぜ、賢いはずのAIがこんなミスをしてしまうのでしょうか。

この記事では、ハルシネーションの正体から、その原因、そして私たちが騙されないための具体的な対策まで、専門用語を噛み砕いて徹底的に解説します。

\ AIスキルを短期間で伸ばしたい方へ /

ChatGPT・動画生成AI・画像AIを体系的に学べる講座。初心者でも安心のサポート付きで、最短10日で実務レベルに到達できます。

バイテック無料カウンセリングを見る1. 生成AIの「ハルシネーション(幻覚)」とは?

「ハルシネーション(Hallucination)」とは、直訳すると「幻覚」という意味です。

AIの分野では、「AIが事実に基づかない情報を、あたかも真実であるかのように生成してしまう現象」を指します。

ハルシネーションの恐ろしさは「もっともらしさ」にある

AIの嘘は、一見すると非常に論理的で、正しい日本語(あるいは外国語)で書かれています。

- 実在しない観光地を、周辺のホテル情報まで含めて紹介する。

- 存在しない法律の条文を、それらしい番号付きで解説する。

- 聞いたことがない成分が健康に良いと勧めてくる。

このように、一見して「間違い」だと気づきにくいのがハルシネーションの最大の特徴であり、注意すべき点です。AIには「人間を騙そう」という悪意はありません。ただ、指示されたことに答えようとした結果、「知識の隙間を創作で埋めてしまった」状態なのです。

2. なぜ「ハルシネーション(幻覚)」と呼ぶのか?その語源

なぜ「間違い」や「エラー」ではなく、わざわざ「幻覚」という言葉が使われるのでしょうか。

もともとは心理学・医学の言葉

ハルシネーションは本来、心理学や医学の用語です。

「対象となる物が実際には存在しないのに、あるように知覚すること」を指します。

AIへの転用の背景

AI(特に大規模言語モデル)は、膨大なデータを学習し、それをもとに新しい文章を作り出します。しかし、時には学習したデータの繋がりを「誤認」し、現実には存在しない文脈を作り上げてしまいます。

この、「データという現実に基づかない世界を、AIが見て(出力して)しまっている状態」が、人間が実在しないものを見る「幻覚」の症状に似ていることから、研究者の間でこの「ハルシネーション」という言葉が使われるようになりました。

今では、AIの不正確さを表す標準的な用語として定着しています。

3. なぜAIは嘘をついてしまう?主な3つの原因

AIがハルシネーションを起こすのには、現在のAIの仕組みに起因する明確な理由があります。

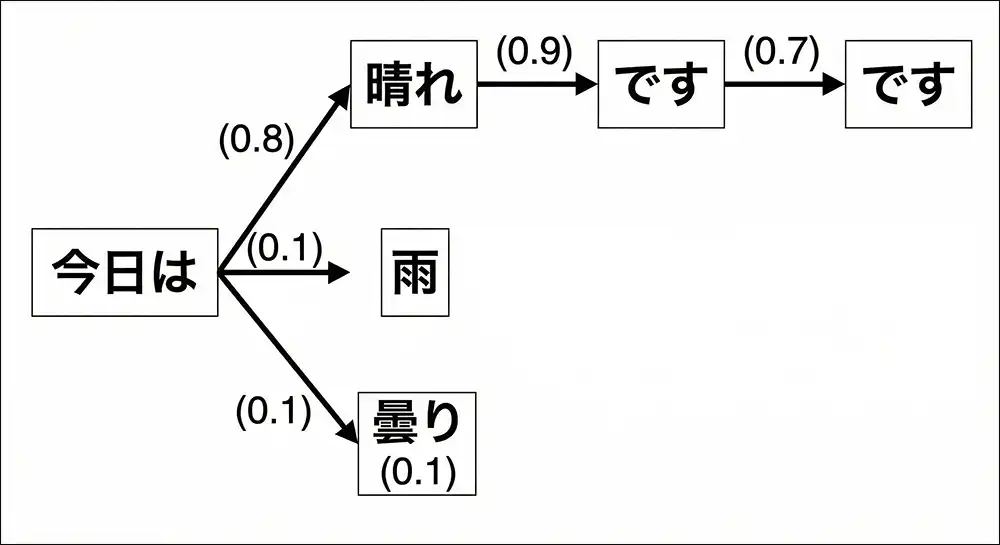

① 「次に来る言葉」を予測する仕組み

AIは、私たちが考えるような「意味を理解して思考する」存在ではありません。

実は、「ある言葉の次にくる確率が最も高い言葉」を予測して繋げている巨大な計算機なのです。

例えば「明日の天気は……」と入力されたら、統計的に次にきそうな「晴れです」という言葉を選んでいるに過ぎません。この確率的な予測が、事実関係よりも「文章としての自然さ」を優先してしまったとき、ハルシネーションが発生します。

② 学習データの限界と「知識のカットオフ」

AIは魔法の箱ではなく、過去の膨大なデータを学習して動いています。そのため、以下のケースで嘘をつきやすくなります。

- 学習データ自体が間違っている: ネット上の誤った情報を信じ込んでしまった。

- 情報が古い(カットオフ): AIが学習を終えた後の最新ニュースについては知らないため、無理に推測して答えてしまう。

③ 「分かりません」が苦手(最適化の問題)

多くの生成AIは、ユーザーの質問に対して「何らかの回答を出すこと」を目標に訓練されています。そのため、自分の知らない範囲の質問に対しても、沈黙するのではなく、手持ちの知識を組み合わせて「それっぽい回答」を無理やり捏造してしまう傾向があるのです。

1. Googleの時価総額が1,000億ドル(約13兆円)以上急落

2023年2月、Googleが対話型AI「Bard(現在のGemini)」を公開した際、プロモーション動画の中でハルシネーションが発生しました。

- 内容: AIが「ジェイムズ・ウェッブ宇宙望遠鏡が、太陽系外惑星の最初の写真を撮った」と回答。

- 事実: 実際には別の望遠鏡(VLT)が2004年に撮影済みでした。

- 影響: 広告動画内でのミスだったため、AIの精度に対する不安が広がり、親会社アルファベットの株価が1日で約8%近く下落。約13兆円もの時価総額が吹き飛ぶ事態となりました。

2. 弁護士が「架空の判例」を裁判所に提出

2023年、ニューヨークの弁護士がChatGPTを使って作成した書類を裁判所に提出しましたが、その内容に重大な問題がありました。

- 内容: AIが、実在しない「架空の過去の裁判例」を6件捏造し、もっともらしい事件番号や判決内容を生成しました。

- 事実: 相手方の弁護士や裁判官が調べてもそれらの判例が見つからず、捏造が発覚。

- 影響: 担当した弁護士は裁判所から5,000ドルの罰金を科されただけでなく、30年以上のキャリアに大きな傷を負うことになりました。

3. 航空会社のチャットボットが勝手に「割引」を約束

2024年、エア・カナダの公式チャットボットが顧客に対して誤った情報を案内し、裁判沙汰になりました。

- 内容: 遺族割引について質問した顧客に対し、AIが「航空券を購入した後からでも返金申請が可能」という、実際には存在しないポリシーを勝手に回答。

- 事実: 実際の規定では、購入後の申請は認められていませんでした。

- 影響: 航空会社側は「チャットボットは独立した法的主体であり、責任はボットにある(会社は責任を負わない)」と主張しましたが、裁判所はこれを却下。「公式サイトの一部である以上、会社が責任を負うべき」として、差額の支払いを命じる判決を下しました。

その他の小規模・身近なトラブル例

- 観光案内: マイクロソフトのニュースサイトでAIが生成した旅行ガイドが、カナダの「フードバンク(困窮者への食料支援施設)」を観光スポットとして紹介し、「空腹で行くのがおすすめ」という不適切なコメントを添えて公開された。

- 教育現場: 大学教授が「学生の論文がAI製かどうか」をChatGPTに判定させたところ、AIが「私が書きました(ハルシネーション)」と誤回答。全員の単位が保留になる騒動が発生した。

4. ハルシネーションに騙されないための4つの対策

AIと上手に付き合うためには、「AIは嘘をつくもの」という前提で、以下の対策を取り入れることが重要です。

① 常に「ファクトチェック」を行う

仕事や重要な判断にAIの回答を使う場合は、必ず一次ソース(公式サイト、公的機関の統計、書籍など)で裏取りをしてください。

AIは「下書き作成」や「アイデア出し」には最適ですが、「事実確認のツール」としてはまだ不完全です。

② プロンプト(指示文)を工夫する

AIに嘘をつかせないための指示として、プロンプトに以下のフレーズを付け加えるのが効果的です。

- 「知らない、または確信がない場合は、無理に答えず『分かりません』と答えてください」

- 「回答の根拠となるソース(URLなど)を提示してください」

(※ただし、URL自体を捏造することもあるので注意!)

③ 複数のAIで「聞き比べ」をする

ChatGPT、Google Gemini、Claudeなど、異なるメーカーのAIに同じ質問を投げてみましょう。複数のAIが同じ回答をしていれば信憑性は高まりますが、回答がバラバラであれば、ハルシネーションを疑うべきサインです。

こういった場合は複数のAIを同時実行できる「天秤AI]などを利用すると良いでしょう。

④ 検索機能付きのAI(RAG)を活用する

最新のAIには、回答を生成する直前にインターネットを検索し、その検索結果に基づいて回答する機能(Perplexity AIや、各AIの検索モード)があります。

これらを使うことで、最新かつ事実に基づいた回答を得やすくなります。

開発元はどう考えている?OpenAIやGoogleが公式に認める「AIの限界」

ハルシネーション(幻覚)は、単なるバグや一時的な不具合ではありません。世界最高峰のAI開発企業であるOpenAIやGoogleも、これが現在のAI技術における本質的な課題であることを公式文書で認めています。

開発トップ企業がこの問題をどう説明し、どう克服しようとしているのか。

その「1次情報」を紐解くことで、私たちがAIとどう向き合うべきかのヒントが見えてきます。

OpenAIの見解:AIは「事実」ではなく「確率」で動いている

ChatGPTの開発元であるOpenAIは、公式なテクニカルレポートやブログの中で、ハルシネーションのメカニズムについて繰り返し言及しています。

OpenAIの説明を要約すると、AIは「膨大な知識を持つ図書館」ではなく、「次に来る言葉を予想する天才的な予測マシン」であるということです。

- 統計的な予測の代償: AIは言葉と言葉の「繋がりやすさ」の確率を計算して文章を作ります。そのため、事実(Fact)よりも、文章としての自然さ(Fluency)が勝ってしまった時に嘘が生まれます。

- 今後のアプローチ: OpenAIは「o1(オーワン)」シリーズのような最新モデルにおいて、回答する前にAI自身に「思考のプロセス」をたどらせる手法を導入しました。これにより、一歩立ち止まって論理を確認させることで、ハルシネーションを大幅に減らす努力を続けています。

Googleの見解:重要なのは「グラウンディング(根拠付け)」

Google(Geminiの開発元)は、ハルシネーション対策として「グラウンディング」という概念を非常に重視しています。

グラウンディングとは、簡単に言えば「AIの回答を、現実世界の信頼できる情報(Google検索など)に結びつけること」です。

- 「Googleボタン」の意図: Geminiの回答の下にある「G」のアイコン(若しくは「その他(三点リーダー)」の中の「回答を再確認」)は、まさに「AIの回答がネット上の情報と一致しているか」をユーザー自身がワンクリックで検証できるようにするためのものです。

- 公式ドキュメントでの指摘: Googleは、AIが「自分の知らないこと」を無理に答えようとする性質があることを認めており、最新の情報を扱う際は、AIの内部メモリだけに頼らず、必ずリアルタイムの検索結果を併用(RAGという技術)することを推奨しています。

1次情報から分かる「共通の結論」

両社の公式情報をまとめると、共通して以下のメッセージが読み取れます。

「現在のAIは、100%の正確性を保証するように設計されているわけではない。しかし、人間が適切な道具(検索機能など)を使い、最終的な確認を行うことで、その能力を最大限に引き出すことができる。」

つまり、開発元も「AIの嘘」を隠そうとしているわけではありません。むしろ、その限界を正しく理解した上で、人間が賢くコントロールすることを求めているのです。

【FAQ】ハルシネーションに関するよくある質問

- Qハルシネーションは将来的にゼロになりますか?

- A

技術の進歩により激減していますが、完全にゼロにするのは難しいと言われています。AIが言葉の確率に基づいている以上、わずかな確率で「あり得ない組み合わせ」が選ばれる可能性があるためです。

- Qどんな分野でハルシネーションが起きやすいですか?

- A

専門的な法律・医療知識、個人のプライバシーに関わる情報、昨日のニュースなどの最新情報、またマイナーな地名や歴史などの「学習データが少ない分野」で発生しやすい傾向があります。

- Q有料版のAIなら嘘をつきませんか?

- A

有料版(GPT-5など)は無料版に比べて精度が非常に高く、ハルシネーションも抑えられていますが、ゼロではありません。過信は禁物です。

5. まとめ:AIと上手に付き合うコツ

ハルシネーションは、現在のAI技術における宿命のようなものです。しかし、「AIは嘘をつくから使えない」と切り捨ててしまうのはもったいありません。

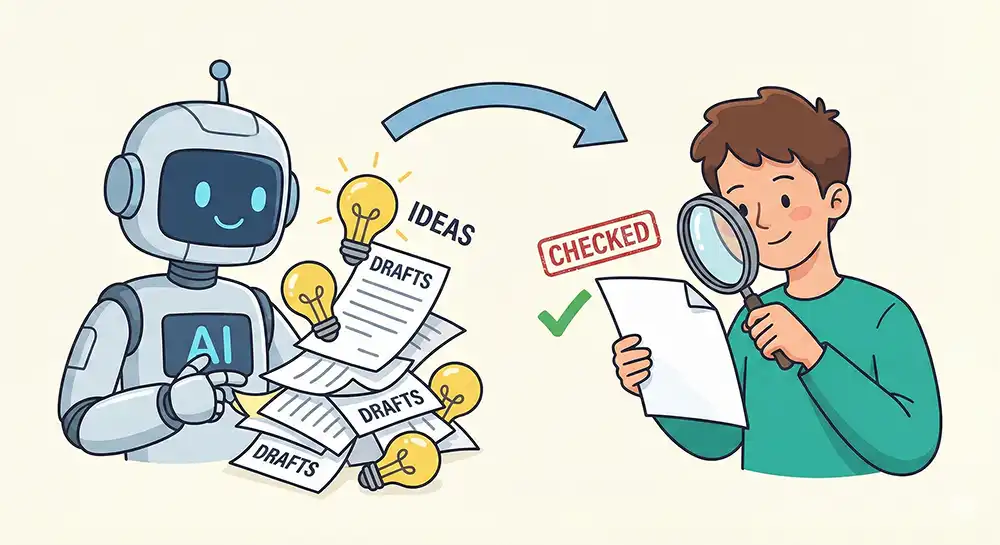

- AIは「創造力豊かなアシスタント」

- 人間は「冷静な校閲者(チェック担当)」

この役割分担を意識するだけで、AI利用の安全性は飛躍的に高まります。AIの特性を正しく理解し、便利な道具として賢く使いこなしていきましょう。

関連記事

- 複数AIを一括比較!天秤AI使い方マニュアル【初心者向け】

- 第29回:AIで学習効率アップ!分からないことをすぐに解決してくれるAIの力

- 第36回:生成AIはこれからどうなる?未来の生成AIと私たちの暮らし

- 第42回:生成AIの「できないこと」を知っておこう!過信は禁物、AIの限界

参考情報

- Google Cloud:AI ハルシネーションとは

- OpenAI:言語モデルでハルシネーションがおきる理由

- OpenAI:安全評価ハブ

コメント